Distribuția Gauss

Distribuția normală este o distribuție de probabilitate continuă. Este numită de asemenea distribuția Gauss deoarece a fost descoperită de către Carl Friedrich Gauss.[1]

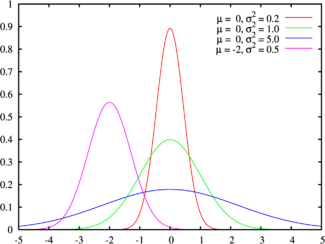

Distribuția normală standard (cunoscută,de asemenea, sub numele de distribuție Z) este distribuția normală cu media zero și variația 1 (curbele verzi în imaginea din dreapta). Acesta este adesea numită curba lui Gauss, deoarece graficul densității de probabilitate arată ca un clopot.

Se notează cu: N(μ,σ), unde μ și σ sunt parametrii din funcția de distribuție care va fi descrisă în continuare.

Proprietăți[modificare | modificare sursă]

Densitatea de repartiție[modificare | modificare sursă]

Media[modificare | modificare sursă]

= = =

Dispersia pentru o variabilă aleatoare continuă[modificare | modificare sursă]

===

Entropia informațională[modificare | modificare sursă]

= =

Funcția de repartiție cumulativă[modificare | modificare sursă]

Funcția de repartiție cumulativă este funcția

- ==

Pentru repartiția N(0,1), această funcție este numită "funcția lui Laplace", și este dată de

- =

Pentru o repartiție normală oarecare N(μ,σ), se verifică prin schimbarea de variabilă x->(x-μ)/σ că

- =

Repartiția variabilei (X-μ)/σ[modificare | modificare sursă]

Pornind de la proprietățile operatorilor de medie și dispersie

- M(X − μ) = M(X)− μ

- D(X − μ) = D(X)

- D(X/σ)=(1/σ2) D(X)

se obține că, dacă o variabilă aleatoare este normal repartizată N(μ,σ), atunci variabila aleatoare redusă

este repartizată N(0,1).

Suma a n variabile independente având repartițiile N(μk,σk)[modificare | modificare sursă]

Dacă Xk:N(μk,σk), k=1,...,n - sunt variabile aleatoare independente, atunci suma lor X1+X2+...+Xn are repartiția:[6]

Ca o consecință imediată a acestui rezultat:

Media aritmetică a n variabile independente având repartiția N(μ,σ)[modificare | modificare sursă]

Dacă Xk:N(μ,σ), k=1,...,n - sunt variabile aleatoare independente, atunci media lor aritmetică (X1+X2+...+Xn)/n are repartiția:

Teorema limită centrală (Laplace)[modificare | modificare sursă]

Reprezintă una din cele mai puternice și mai utilizate proprietăți ale distribuției Gauss. Teorema este următoarea:

Dacă Xk - sunt variabile aleatoare independente având aceeași medie și dispersia , atunci limita mediei lor aritmetice (X1+X2+...+Xn)/n atunci cand are proprietatea:

Rezultă că se aproximează cu pentru

Regula celor 3σ[modificare | modificare sursă]

O variabilă normal repartizată X:N(μ,σ) ia valori semnificative numai în intervalul (μ-3σ,μ+3σ). Într-adevăr, , valoare care în unele situații poate fi neglijată.

Note[modificare | modificare sursă]

- ^ Kirkwood, Betty R; Sterne, Jonathan AC (). Essential Medical Statistics. Blackwell Science Ltd.

- ^ Viorel Petrehuș, Sever-Angel Popescu, Probabilități și statistică, Arhivat în , la Wayback Machine., Universitatea Tehnică de Construcții din București, 2005

- ^ „copie arhivă” (PDF). Arhivat din original la . Accesat în .

- ^ Ștefan Balint, Éva Kaslik, Simina Ștefania Mariș, Probabilități (curs), Universitatea de Vest din Timișoara, Arhivat în , la Wayback Machine.

- ^ Ariadna Lucia Pletea,Liliana Popa, [math.etti.tuiasi.ro/lpopa/cursTP.pdf/ Teoria probabilităților] (curs, 1999), Universitatea Tehnică „Gheorghe Asachi” din Iași

- ^ H. Poincaré-Calcul des probabilités, Gauthiers-Villars,Paris,1912/

Vezi și[modificare | modificare sursă]

- Distribuție de probabilitate

- Distribuția binomială

- Distribuția Rayleigh

- Variabilă aleatoare

- Rugozitate#Filtre

Legături externe[modificare | modificare sursă]

- en Free Area Under the Normal Curve Calculator from Daniel Soper's Free Statistics Calculators website. Computes the cumulative area under the normal curve (i.e., the cumulative probability), given a z-score.

- en Interactive Distribution Modeler (incl. Normal Distribution).

- en GNU Scientific Library – Reference Manual – The Gaussian Distribution

- en Normal Distribution Table

- en Download free two-way normal distribution calculator

- en Download free normal distribution fitting software

- en http://www.pruteanu.ro/704reflec_files/gauss.htm Arhivat în , la Wayback Machine.

![{\displaystyle H[f]=-\int \limits _{-\infty }^{\infty }f(x)\ln(f(x))\,dx}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c4f447acda1684e814968c5f2a1aaadddd10a099)