Varianță

În teoria probabilității și statistică, varianța reprezintă media deviațiilor pătratice a unei variabile aleatoare de la media sa. Informal spus, măsoară depărtarea valorilor individuale (aleatoare) dintr-o mulțime, de la media lor. Varianța are un rol crucial în statistică, fiind folosită în statistica descriptivă, statistica inferențială, testarea ipotezelor, calitatea modelării și metodele Monte Carlo. Astfel de metode statistice se folosesc pretutindeni în știință. Varianța reprezintă pătratul deviației standard, al doilea moment central al unei distribuții, și covarianța unei variabile aleatoare cu sine însuși, fiind adesea reprezentată prin , sau .

Definiție

[modificare | modificare sursă]Varianța unei variabile aleatoare este speranța matematică (i.e. media) a deviațiilor pătratice de la media lui , :

Această definiție cuprinde variabile aleatoare ce pot fi generate de procese discrete, continue, mixte sau Cantoriene. Varianța poate fi, de asemenea, definită ca reprezentând covarianța unei variabile aleatoare cu sine însăși:

Varianța este echivalentă cu al doilea cumulant al unei distribuții de probabilitate ce generează . Varianța este desemnată prin , , sau (pronunțat "sigma pătrat"). Expresia varianței poate fi dezvoltată:

Cu alte cuvinte, variația lui X este egală cu media valorilor pătratice ale lui X minus pătratul mediei lui X. Această ecuația nu trebuie folosită în programe de calcul ce folosesc virgula mobilă datorită fenomenului de reducere numerică ce apare când cei doi termeni au mărimi identice. Există alternative în algoritmii stabili numeric.

Variabilă aleatoare discretă

[modificare | modificare sursă]Dacă distribuția variabilei aleatoare este discretă, având funcția de masă , atunci:

sau echivalent:

unde reprezintă speranța matematică (i.e media distribuției):

(În cazul în care suma ponderilor valorilor individuale nu este egală cu 1, atunci ecuația de mai sus trebuie împărțită la respectiva sumă).

Varianța unei mulțimi de elemente, având probabilități echivalente, poate fi scrisă ca:

unde este valoarea medie, adică,

Varianța poate fi exprimată și fără referirea directă la medie, ca reprezentând deviațiile pătratice a tuturor valorilor de la fiecare valoare în parte. Pentru o mulțime de elemente, având probabilități echivalente, avem: [1]

Variabilă aleatoare continuă

[modificare | modificare sursă]Dacă variabila este generată de o distribuție continuă cu o funcție de densitate de probabilitate , și este funcția de distribuție cumulativă corespunzătoare, atunci varianța populației este dată de:

sau echivalent, putem scrie

Unde reprezintă speranța matematică (i.e. media) a lui dată de:

cu integrale definite pe intervalul variabilei .

Dacă o distribuție continuă nu are o speranță matematică finită (i.e. medie), cum este cazul distribuției Cauchy, nu poate avea nici varianță. Multe alte distribuții pentru care speranța matematică este finită, nu au varianță (finită) pentru că integrala varianței este divergentă. Un astfel de exemplu este dat de distribuția Pareto, al cărui index satisface .

Exemple

[modificare | modificare sursă]Distribuția normală

[modificare | modificare sursă]Distribuția normală cu parametrii și este o distribuție continuă (cunoscută și sub numele de distribuție Gaussiană) a cărei funcție de densitate a probabilității este dată de:

În această distribuție, și varianța sunt legate de prin:

Rolul distribuției normale în teoria limitei centrale este, în parte, responsabilă pentru prevalența varianței în probabilitate și statistică.

Distribuția exponențială

[modificare | modificare sursă]Distribuția exponențială cu paramentrul este o distribuție continuă definită pe intervalul semi-infinit . Funcția densității de probabilitate este dată de:

, având o speranță matematică (i.e. medie) egală cu . Prin urmare, varianța este egală cu:

De aici rezultă că, pentru distribuția exponențială, avem relația

Distribuția Poisson

[modificare | modificare sursă]Singurul ei parametru este . Distribuția Poisson este o distribuție discretă pentru . Funcția de masă a probabilității este:

iar speranța matematică (i.e. media) este: . Astfel, varianța este egală cu:

De aici rezultă că, pentru distribuția Poisson, avem relația: .

Distribuția binomială

[modificare | modificare sursă]Parametrii săi sunt și . Distribuția este o distribuție discretă pentru . Funcția de masă a probabilității este:

iar speranța matematică (i.e. media) este . Astfel, varianța este egală cu:

Spre exemplu, distribuția binomială cu descrie probabilitatea de a obține de ori o oarecare față (exp. ban) în cazul aruncării unei monede de ori. Deci, speranța matematică (i.e. media) pentru a obține una dintre fețe este , iar varianța este

Aruncarea cu zarul

[modificare | modificare sursă]Un zar cu șase fețe poate fi modelat, conform distribuției binomiale, ca o distribuție cu variabilă discretă X , ce poate lua valori de la 1 la 6, fiecare cu probabilitate egală de 1/6. Speranța matematică (i.e. media) a lui X este Prin urmare, varianța lui X este:

Formula generală pentru varianța lui X , dacă avem un zar cu n fețe n-sided, este:

Proprietăți

[modificare | modificare sursă]Proprietăți fundamentale

[modificare | modificare sursă]Varianța este non-negativă, deoarece din ridicarea la pătrat poate rezulta doar un număr pozitiv sau zero:

Varianța unei variabile aleatoare constante este zero, și, invers, dacă varianța unei variabile este zero, atunci variabila este o constantă:

Varianța este invariabilă relativ la schimbările parametrului de poziție. Astfel, dacă o constantă este adăugată (prin adiție) tuturor valorilor pe care le ia variabila, varianța rămâne neschimbată:

Dacă toate valorile variabilei sunt multiplicate cu o constantă, varianța variabilei este multiplicată cu pătratul acelei constante (adică proprietatea de scalare):

Varianța sumei a două variabile aleatoare este dată de relația:

unde Cov(⋅, ⋅) reprezintă covarianța. În general, dacă avem o sumă de variabile aleatoare, , relația se prezintă ca:

Aceste rezultate conduc la varianța combinațiilor liniare:

Dacă variabilele aleatoare sunt astfel încât:

se poate afirma despre ele că sunt necorelate. Rezultă din ecuația combinațiilor liniare că dacă variabilele aleatoare sunt necorelate, varianța sumei lor este egală cu suma varianțelor lor:

Deoarece variabilele aleatoare independente sunt mereu necorelate, ecuația de mai sus este valabilă doar când variabilele aleatoare sunt independente. Prin urmare, independența este o condiție suficientă, dar nu și necesară, pentru ca varianța sumei să fie egală cu suma varianțelor (i.e. ecuația de mai sus să fie adevărată).

Suma variabilelor necorelate (formula lui Bienaymé)

[modificare | modificare sursă]Unul din motivele pentru care varianța este preferată altor măsuri de dispersie este că varianța sumei variabilelor aleatoare necorelate este egală cu suma varianțelor lor:

Această ecuația se numește "formula lui Bienaymé"[2], fiind descoperită în 1853.[3] [4] Deseori presupune condiția ca variabilele să fie independente, deși simpla lipsă de corelare este suficientă. Deci, dacă toate variabilele au aceeași varianță σ2, atunci, deoarece împărțirea cu n este o transformare liniară, formula varianței mediei lor devine:

Aceasta înseamnă că varianța mediei scade atunci când n crește. Această formulă pentru varianța mediei este utilizată în definirea erorii standard a mediei eșantionului, care este utilizată in teorema limitei centrale.

Pentru demonstrarea formulei lui Bienaymé, este suficient să se arate că:

Această formulă poate fi demonstrată prin inducție, pornindu-se de la definiția varianței:

Folosind proprietatea de liniaritate a speranței matematicii (i.e. mediei) și ipoteza independenței variabilelor (sau, cel puțin, a lipsei de corelare) X și Y, ecuația de mai sus se poate dezvolta în felul următor:

Suma variabilelor corelate

[modificare | modificare sursă]În general, dacă variabilele sunt corelate, atunci varianța sumei lor este egală cu suma covarianțelor lor:

(Notă: A doua egalitate se datorează faptului că Cov(Xi,Xi) = Var(Xi))

Aici Cov(⋅, ⋅) reprezintă covarianța, care este zero pentru variabilele aleatoare independente. Formula stipulează că varianța sumei de variabile este egală cu suma tuturor elementelor din matricea de covarianță a variabilelor componente. Următoarea expresie stipulează, în mod echivalent, că varianța sumei de variabile este suma elementelor diagonalei matricei covarianțelor plus de două ori suma elementelor de deasupra diagonalei matricei. Datorită faptului că matricea de covarianță este simetrică, se pot lua în locul elementelor de deasupra diagonalei, elementele de dedesubtul diagonalei. Această formulă se folosește în teoria coeficientului Alpha a lui Cronbach, aceasta fiind esențială în teoria clasică a testării.

Deci dacă variabilele au varianțele egale cu σ 2 și corelația medie a variabilelor este ρ, atunci varianța mediei lor este:

Aceasta implică faptul că varianța mediei crește cu media corelațiilor. Cu alte cuvine, observațiile adiționale corelate nu sunt la fel de efective în reducerea incertitudinii mediei, precum sunt observațiile adiționale independente. Mai mult, dacă variabilele au varianța egală cu 1, în cazul standardizării spre exemplu, formula se simplifică:

Această formulă este încorporată în formula de predicție Spearman-Brown a teoriei clasice a testării. Aceasta converge la ρ dacă n tinde la infinit, presupunând că corelația medie rămâne constantă sau converge de asemenea. Încât, pentru varianța mediei variabilelor standardizate cu corelații constante sau având corelația medie convergentă, obținem:

În concluzie, varianța mediei unui număr mare de variabile standardizate este aproximativ egală cu corelația lor medie. Aceasta înseamnă că media variabilelor corelate ale eșantionului nu converge, în general, la media populației, deși legea numerelor mari stipulează că media eșantionului va converge la media populației dacă variabilele sunt independente.

Notația matricială pentru varianța unei combinații liniare

[modificare | modificare sursă]Fie un vector coloană cu variabile aleatoare <, și un vector coloană cu scalari . Prin urmare, reprezintă o combinație liniară a acestor variabile aleatoare, unde prin este notată transpusa matricei c. De asemenea, fie matricea covarianței lui . Varianța lui este dată de: [5]

Sumă ponderată de variabile

[modificare | modificare sursă]Proprietatea de scalare, formula lui Bienaymé, împreună cu proprietatea covarianței Cov(aX, bY) = ab Cov(X, Y), implică următoarea expresie:

Din cele de mai sus rezultă că efectul ponderării variabilelor (coeficienții a și b) este disproporționat pentru calcularea varianței. Spre exemplu, presupunând că variabilele X și Y sunt necorelate, iar ponderea lui X este de două ori mai mare decât ponderea lui Y (i.e. a = 2b), atunci ponderea lui X în formula varianței va fi de patru ori mai mare decât ponderea lui Y.

Varianța ponderată a n variabile poate fi scrisă ca:

Produs de variabile independente

[modificare | modificare sursă]Dacă două variabile X și Y sunt independente, varianța produsului lor este dată de [6]

Prin manipulări, ecuația poate fi transformată la:

Produs de variabile dependente statistic

[modificare | modificare sursă]În general, dacă două variabile sunt dependente statistic, varianța produsului lor este dată de următoarea formulă:

Descompunere

[modificare | modificare sursă]Formula generală pentru descompunerea varianței, sau legea varianței totale, unde și sunt două variabile aleatoare, iar varianța lui există, este:

Speranța matematică (i.e. media condiționată) a lui dat fiind , și varianța condiționată pot fi înțelese în felul următor: dată fiind o valoare particulară y a variabilei aleatoare Y, există o speranță matematică când Y=y. Această cantitate depinde de valoarea specifică y, fiind o funcție . Aceeași funcție evaluată pentru variabila aleatoare Y reprezintă speranța matematică (i.e. media condiționată)

În particular, dacă este o variabilă aleatoare discretă ce ia valori cu probabilitățile corespunzătoare , atunci formula pentru varianța totală este:

unde . În mod similar, varianța mediei (al doilea termen al formulei generale) devine:

unde și . Astfel, formula varianței total devine:

O formulă similară este folosită în procesul de analiză a varianței (i.e. ANOVA):

unde semnifică media pătratelor (engl. “mean of the squares”). În cazul regresiei liniare, formula devine:

Această formulă poate fi derivată și din proprietatea de aditivitate a varianțelor, de vreme ce varianță totală (observată) este egală cu suma dintre varianță prognozată și varianță reziduală (i.e. eroarea de prognoză), cele două fiind necorelate.

Descompuneri similare sunt posibile pentru suma deviațiilor pătratice :

Proprietate caracteristică

[modificare | modificare sursă]Al doilea moment al unei variabile aleatoare atinge valoarea minimă când este luat în jurul primului moment (care este media) al variabilei aleatoare, i.e. . Invers, dacă o funcție continuă satisface pentru toate variabilele aleatoare X, atunci este neapărat de forma , unde a>0. Aceasta rămâne valabil și în cazul multidimensionalității. [7]

Unități de măsură

[modificare | modificare sursă]Spre deosebire de speranța matematică a deviației absolute, unitatea de măsură a varianței este pătratul unității variabilei. Spre exemplu, o variabilă având unitatea de măsură în metri, va avea varianța măsurată în metri pătrați. Din acest motiv, descrierea unei mulțimi cu ajutorul deviației standard sau a rădăcinii deviației pătratice medii este deseori preferată în locul varianței. În problema aruncării cu zarul, prezentată mai sus, deviația standard este √2,9 ≈ 1,7 - puțin mai mare decât speranță matematică a deviației absolute care este 1.5.

Atât deviația standard, cât și speranța matematică a deviației absolute, pot fi folosite pentru a indica “împrăștierea” unei distribuții. Deviația standard este mai convenabilă manipulărilor algebrice decât speranța matematică a deviației absolute, ambele fiind folosite frecvent, alături de varianță și covarianță, în știința statisticii. Totuși, speranța matematică a deviației absolute tinde să fie mai robustă față de valorile extreme (datorate erorilor de măsurare sau specificității distribuției).

Aproximarea varianței unei funcții

[modificare | modificare sursă]Metoda delta folosește seriile Taylor de ordinul doi pentru a aproxima varianța unei funcții de una sau mai multe variabile aleatoare. Spre exemplu, aproximarea varianței unei funcții de o variabilă este dată de formula:

presupunând că f este dublu diferențiabilă și că media și varianța lui X sunt finite. Pentru mai multe detalii, vezi seria Taylor pentru momentele funcțiilor de variabile aleatoare.

Varianța unei populații și varianța unui eșantion

[modificare | modificare sursă]Observațiile din natură, precum cele privitoare la cantitatea zilnică de precipitații, nu pot fi considerate a fi complete deoarece nu putem înregistra toate fenomenele similare petrecute de la începutul timpului (i.e. toate zilele cu precipitații de la începutul existenței Pământului). Prin urmare, varianța calculată dintr-o mulțime de observații limitate (în timp sau spațiu), nu poate fi egală cu varianța ce ar fi rezultat dacă am fi avut mulțimea exhaustivă de observații (i.e. nelimitate de timp sau spațiu). Aceasta înseamnă că va trebui să estimăm media și varianța mulțimii exhaustive de observații (i.e. a populației) folosind o ecuație estimatoare. Ecuația estimatoare este o funcție de n observații ale unui eșantion extras, fără erori de eșantionare, din întreaga populație de observații posibile.

Cei mai simplii estimatori pentru media și varianța unei populații sunt media și varianța eșantionului, aceștia fiind estimatori consistenți (i.e. converg la valoarea reală odată cu creșterea numărului de eșantioane). Totuși, estimarea varianței eșantionului poate fi îmbunătățită în mai multe feluri. În acest sens, se pot folosi divizori diferiți de n pentru deviațiile pătratice. Ceilalți trei divizori folosiți sunt: n-1, n+1 și n-1,5. Se consideră că n-1 elimină alterarea, n+1 minimizează eroarea pătratică medie pentru distribuția normală, și n – 1,5 elimină alterarea estimatorului deviației standard pentru distribuția normală.

Dacă media populației este necunoscută, fiind calculată pe baza eșantionului, atunci varianța eșantionului este un estimator alterat datorită subestimării varianței cu un factor de (n-1)/n; corectând estimarea cu acest factor (și deci împărțind deviațiile pătratice cu n-1 în loc de n), se numește corecția lui Bessel. Estimatorul rezultat este nealterat, numindu-se varianța corectată a eșantionului sau varianța nealterată a eșantionului. Spre exemplu, dacă avem o singură observație într-un eșantion (i.e. media în sine), varianța eșantionului este evident zero, indiferent de varianța reală a populației. Acest fapt nu ar mai fi valabil dacă s-ar cunoaște media populației (sau ar putea fi estimată dintr-un alt eșantion decât cel din care este estimată varianța), caz în care varianța poate fi estimată prin împărțire la n. În exemplul cu o singură observație, varianța ar fi egală cu deviația pătratică a observației de la media (estimată a) populației.

Pe de altă parte, varianța eșantionului nu minimizează eroarea pătratică medie între varianța eșantionului și varianța populației. Folosind corecția lui Bessel înrăutățește estimarea erorii pătratice medii. De aceea, în acest caz se folosește un factor de scalare (i.e. de proporționare) mai mare decat (n-1), împărțindu-se varianța eșantionului, în cazul distribuției normale, la (n+1) pentru a minimiza eroarea pătratică medie. În acest caz folosim totuși o variație alterată a eșantionului.

Varianța populației

[modificare | modificare sursă]În general, varianța unei populații finite de mărime N, cu valori xi este dată de:

unde media populației este:

Varianța populației poate fi calculată și folosind următoarea formulă:

Aceasta este validă, deoarece:

Varianța populației corespunde varianței disitributiei de probabilitate aferente, de aceea conceptul de populație poate fi extins pentru distribuții de probabilitate continue, având mărimi infinite. .

Varianța eșantionului

[modificare | modificare sursă]În multe situații practice, varianța populației nu poate fi cunoscută a priori, trebuind a fi estimată prin alegerea unui eșantion.[8] Ca și în cazul varianței populației, varianța eșantionului poate fi calculată și pentru o distribuție continuă aferentă distribuției populației.

Fie un eșantion cu n valori Y 1 , . . .,Y n extras dintr-o anumită populație N, unde n < N. [9] Atunci varianța eșantionului este dată de media deviațiilor pătratice:

Aici, denotă media eșantionului:

Deoarece Yi au fost selectate aleatoriu, atât cât și < sunt variabile aleatoare. Speranța lor matematică poate fi evaluată prin luarea mediei estimatorilor aferenți tuturor eșantioanelor posibile { Yi } de mărime n din populație. Așa încât, pentru avem:

Prin urmare este o estimare a varianței populației ce este alterată cu un factor de . Din acest motiv, se numește varianța alterată a eșantionului. Corectând această alterație, obținem varianța nealterată a eșantionului:

Corecția Bassel (n-1) se folosește și în calcularea covarianței eșantionului și a deviației standard a eșantionului (i.e. rădăcina pătrată a varianței). Rădăcina pătrată este o funcție concavă, introducând astfel alterația negativă (conform inegalității lui Jensen), ceea ce, depinzând de distribuție, face ca deviația standard folosind corecția Basel să fie alterată în acest caz. Estimarea deviației standard nealterate este o problemă tehnică complicată, deși pentru distribuția normală se poate folosi divizorul (n -1,5) din care rezultă un estimator al deviației standard aproape nealterat. .

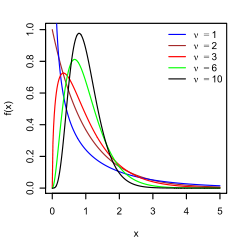

Distribuția varianței eșantionului

[modificare | modificare sursă]Fiind o funcție de variabile aleatoare, varianța eșantionului este ea însăși o variabilă aleatoare, fiind astfel justificat să-i studiem distribuția. În cazul în care Yi sunt observații independente ale unei distribuții normale, teorema lui Cochran arată că S2 se conformează unei distribuții chi-pătrat : [10]

O consecință directă a acestui fapt este că:

și [11]

Dacă valorile Yi sunt independente și identic distribuite, dar nu necesar și normal distribuite, atunci:[12] [13]

unde κ este aplatizarea (i.e. kurtotizarea) distribuției, iar μ4 este al patrulea moment central.

Dacă legea numerelor mari este valabilă pentru observațiile pătratice, s2 este un estimator consistent al σ2. Poate fi demonstrat că varianța estimatorilor tinde asimptotic către zero. O formulă asimptotică echivalentă a fost dată în Kenney and Keeping (1951: 164), Rose and Smith (2002: 264), și Weisstein (n.d.). [14] [15] [16]

Inegalitatea lui Samuelson

[modificare | modificare sursă]Inegalitatea lui Samuelson este un rezultat care stipulează limite pentru valorile ce pot fi luate de observațiile individuale dintr-un eșantion, presupunând că acel eșantion are medie și varianță [17] Conform acesteia, valorile trebuie să fie cuprinse în intervalul:

Relații cu media armonică și media aritmetică

[modificare | modificare sursă]A fost arătat că pentru un eșantion [18] { yi } de numere reale,

unde y max reprezintă valoarea maximă a eșantionului, A este media aritmetică, H este media armonică a eșantionului și este varianța (alterată) a eșantionului.

Ulterior, acest interval a fost dezvoltat, încât s-a ajuns la următorul interval de mărginire a varianței:

unde y min este valoarea minimă a eșantionului. [19]

Istorie

[modificare | modificare sursă]Termenul de varianță a fost introdus prima dată de Ronald Fisher într-un articol din 1918 intitulat The Correlation Between Relatives on the Supposition of Mendelian Inheritance: [20]

Marea literatură statistică ne arată cum deviațiile măsurătorilor umane de la medie urmează îndeaproape Legea Normală a Erorilor, și, prin urmare, că variabilitatea poate fi măsurată uniform cu ajutorul deviației standard corespunzătoare rădăcinii pătratice a erorii pătratice medii. Când există două cauze independente cauzatoare de variabilitate într-o distribuție uniformă cu deviațiile standard și , se găsește că distribuția, atunci când cauzele acționează împreună, are o deviație standard de . Este prin urmare de dorit în analizarea cauzelor variabilității să ne ocupăm de pătratul deviației standard ca măsură a variabilității. Vom numi această cantitate “varianță”...

- Distribuția frecvențială este construită

- Identificând centroidul distribuției găsim media ei

- Câte-un pătrat cu latura egală cu diferența valorii individuale de la medie este format pentru fiecare valoare individuală

- Aranjând pătratele într-un dreptunghi cu o latură egală cu numărul de valori n, rezultă în revelarea de către cealaltă latură a varianței distribuției, σ².

Semivarianța

[modificare | modificare sursă]Semivarianța este calculată asemenea varianței, însă doar acele observații mai mici decât media sunt luate în considerare. Uneori este descrisă ca fiind riscul de pierderi într-un context investițional. Pentru distribuții asimetrice, semivarianța poate oferi informații adiționale pe care varianța le ignoră. [necesită citare]

Semivarianța poate fi folosită și pentru a determina intervalul de valori pe care o distribuție o poate lua în jurul mediei, conform inegalității lui Chebyshev.

Generalizări

[modificare | modificare sursă]Pentru variabile complexe

[modificare | modificare sursă]Dacă este o variabilă aleatoare complexă scalară, cu valori în atunci varianța sa este , unde este conjugata complexă a lui . Această varianță este un scalar real.

Pentru variabile vectoriale aleatoare

[modificare | modificare sursă]Ca matrice

[modificare | modificare sursă]Dacă este un vector coloană ce cuprinde valori aleatoare, cu valori în , atunci o generalizare naturală a varianței este unde este transpusa lui , fiind astfel un vector linie. Rezultatul este o matrice pătratică semidefinită, cunoscută sub numele de matricea varianță-covarianță (sau, mai simplu, matricea covarianței).

Dacă este un vector coloană ce cuprinde valori aleatoare, cu valori în atunci matricea covarianței este , unde este transpusa conjugată a lui Și această matrice este pătratică și pozitiv semidefinită.

Ca scalar

[modificare | modificare sursă]O altă generalizare a varianței pentru valori vectoriale de variabile aleatoare care rezultă într-o valoare scalară în loc de structură matriceală, este obținută prin interpretarea deviației dintre variabila aleatoare și media sa ca distanță Euclidiană. Rezultatul este că ceea ce reprezintă o urmă matriceală a matricei covarianței.

Vezi și

[modificare | modificare sursă]Note

[modificare | modificare sursă]- ^ Yuli Zhang, Huaiyu Wu, Lei Cheng (iunie 2012). Some new deformation formulas about variance and covariance. Proceedings of 4th International Conference on Modelling, Identification and Control(ICMIC2012). pp. 987–992.

- ^ Loève, M. (1977) "Probability Theory", Graduate Texts in Mathematics, Volume 45, 4th edition, Springer-Verlag, p. 12.

- ^ Bienaymé, I.-J. (1853) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Comptes rendus de l'Académie des sciences Paris, 37, p. 309–317; digital copy available [1]

- ^ Bienaymé, I.-J. (1867) "Considérations à l'appui de la découverte de Laplace sur la loi de probabilité dans la méthode des moindres carrés", Journal de Mathématiques Pures et Appliquées, Série 2, Tome 12, p. 158–167; digital copy available [2][3]

- ^ Johnson, Richard; Wichern, Dean (). Applied Multivariate Statistical Analysis. Prentice Hall. p. 76. ISBN 0-13-187715-1.

- ^ Goodman, Leo A. (decembrie 1960). „On the Exact Variance of Products”. Journal of the American Statistical Association. 55 (292): 708. doi:10.2307/2281592. JSTOR 2281592.

- ^ Kagan, A.; Shepp, L. A. (). „Why the variance?”. Statistics & Probability Letters. 38 (4): 329–333. doi:10.1016/S0167-7152(98)00041-8.

- ^ Navidi, William (2006) Statistics for Engineers and Scientists, McGraw-Hill, pg 14.

- ^ Montgomery, D. C. and Runger, G. C. (1994) Applied statistics and probability for engineers, page 201. John Wiley & Sons New York

- ^ Knight K. (2000), Mathematical Statistics, Chapman and Hall, New York. (proposition 2.11)

- ^ Casella and Berger (2002) Statistical Inference, Example 7.3.3, p. 331 [referință neconformată]

- ^ Cho, Eungchun; Cho, Moon Jung; Eltinge, John (2005) The Variance of Sample Variance From a Finite Population. International Journal of Pure and Applied Mathematics 21 (3): 387-394. http://www.ijpam.eu/contents/2005-21-3/10/10.pdf

- ^ Cho, Eungchun; Cho, Moon Jung (2009) Variance of Sample Variance With Replacement. International Journal of Pure and Applied Mathematics 52 (1): 43–47. http://www.ijpam.eu/contents/2009-52-1/5/5.pdf

- ^ Kenney, John F.; Keeping, E.S. (1951) Mathematics of Statistics. Part Two. 2nd ed. D. Van Nostrand Company, Inc. Princeton: New Jersey. http://krishikosh.egranth.ac.in/bitstream/1/2025521/1/G2257.pdf

- ^ Rose, Colin; Smith, Murray D. (2002) Mathematical Statistics with Mathematica. Springer-Verlag, New York. http://www.mathstatica.com/book/Mathematical_Statistics_with_Mathematica.pdf

- ^ Weisstein, Eric W. (n.d.) Sample Variance Distribution. MathWorld—A Wolfram Web Resource. http://mathworld.wolfram.com/SampleVarianceDistribution.html

- ^ Samuelson, Paul (). „How Deviant Can You Be?”. Journal of the American Statistical Association. 63 (324): 1522–1525. doi:10.1080/01621459.1968.10480944. JSTOR 2285901.

- ^ Mercer, A. McD. (). „Bounds for A–G, A–H, G–H, and a family of inequalities of Ky Fan's type, using a general method”. J. Math. Anal. Appl. 243 (1): 163–173. doi:10.1006/jmaa.1999.6688.

- ^ Sharma, R. (). „Some more inequalities for arithmetic mean, harmonic mean and variance”. J. Math. Inequalities. 2 (1): 109–114. doi:10.7153/jmi-02-11.

- ^ Ronald Fisher (1918) The correlation between relatives on the supposition of Mendelian Inheritance

![{\displaystyle \mu =\operatorname {E} [X]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ce1b41598b8e8f45f57c1550ebb8d5c7ab8e1210)

![{\displaystyle \operatorname {Var} (X)=\operatorname {E} \left[(X-\mu )^{2}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/55622d2a1cf5e46f2926ab389a8e3438edb53731)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} \left[(X-\operatorname {E} [X])^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}-2X\operatorname {E} [X]+\operatorname {E} [X]^{2}\right]\\[4pt]&=\operatorname {E} \left[X^{2}\right]-2\operatorname {E} [X]\operatorname {E} [X]+\operatorname {E} [X]^{2}\\[4pt]&=\operatorname {E} \left[X^{2}\right]-\operatorname {E} [X]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ad35c4161b9cf52868e879d457d8d796094ff02)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)=\sigma ^{2}&=\int (x-\mu )^{2}f(x)\,dx\\[4pt]&=\int x^{2}f(x)\,dx-2\mu \int xf(x)\,dx+\int \mu ^{2}f(x)\,dx\\[4pt]&=\int x^{2}\,dF(x)-2\mu \int x\,dF(x)+\mu ^{2}\int \,dF(x)\\[4pt]&=\int x^{2}\,dF(x)-2\mu \cdot \mu +\mu ^{2}\cdot 1\\[4pt]&=\int x^{2}\,dF(x)-\mu ^{2},\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dfbab91c36aaf9c4cb19282ca2c3106c08047f51)

![{\displaystyle \operatorname {E} [X]=\mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/9e19f2ee2d8e606b7b96a6667b3e8cd403851b53)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\sum _{i=1}^{6}{\frac {1}{6}}\left(i-{\frac {7}{2}}\right)^{2}\\[5pt]&={\frac {1}{6}}\left((-5/2)^{2}+(-3/2)^{2}+(-1/2)^{2}+(1/2)^{2}+(3/2)^{2}+(5/2)^{2}\right)\\[5pt]&={\frac {35}{12}}\approx 2.92.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6b1b6a74f544d9422366dc015805d67149030ec7)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X)&=\operatorname {E} (X^{2})-(\operatorname {E} (X))^{2}\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}i^{2}-\left({\frac {1}{n}}\sum _{i=1}^{n}i\right)^{2}\\[5pt]&={\frac {(n+1)(2n+1)}{6}}-\left({\frac {n+1}{2}}\right)^{2}\\[4pt]&={\frac {n^{2}-1}{12}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/499bbaffd7153ce9032f21d6a08645a02591092f)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [(X+Y)^{2}]-(\operatorname {E} [X+Y])^{2}\\[5pt]&=\operatorname {E} [X^{2}+2XY+Y^{2}]-(\operatorname {E} [X]+\operatorname {E} [Y])^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aaaff2b45438d2d3b2b7b871a22172410f1ad838)

![{\displaystyle {\begin{aligned}\operatorname {Var} (X+Y)&=\operatorname {E} [X^{2}]+2\operatorname {E} [XY]+\operatorname {E} [Y^{2}]-(\operatorname {E} [X]^{2}+2\operatorname {E} [X]\operatorname {E} [Y]+\operatorname {E} [Y]^{2})\\[5pt]&=\operatorname {E} [X^{2}]+\operatorname {E} [Y^{2}]-\operatorname {E} [X]^{2}-\operatorname {E} [Y]^{2}\\[5pt]&=\operatorname {Var} (X)+\operatorname {Var} (Y).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/66abdfcab0297cc33b03880b44fa68fca5d83872)

![{\displaystyle {\begin{aligned}\operatorname {Var} (XY)&=[\operatorname {E} (X)]^{2}\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2}\operatorname {Var} (X)+\operatorname {Var} (X)\operatorname {Var} (Y).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/16469e09583d6883bb5e28639939b2a4f14c5435)

![{\displaystyle \operatorname {Var} (XY)=\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (X)]^{2}[\operatorname {E} (Y)]^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5542bf0e4e8a6553ce4b2283b91160208ead6ab4)

![{\displaystyle {\begin{aligned}\operatorname {Var} (XY)={}&\operatorname {E} [X^{2}Y^{2}]-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+\operatorname {E} (X^{2})\operatorname {E} (Y^{2})-[\operatorname {E} (XY)]^{2}\\[5pt]={}&\operatorname {Cov} (X^{2},Y^{2})+(\operatorname {Var} (X)+[\operatorname {E} (X)]^{2})(\operatorname {Var} (Y)+[\operatorname {E} (Y)]^{2})\\[5pt]&{}-[\operatorname {Cov} (X,Y)+\operatorname {E} (X)\operatorname {E} (Y)]^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cf52cafcb57f318cd8800340108665b6dfb3185)

![{\displaystyle \operatorname {Var} [X]=\operatorname {E} (\operatorname {Var} [X\mid Y])+\operatorname {Var} (\operatorname {E} [X\mid Y]).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d096b66af734c89681ab5cb61b24fbea63a48669)

![{\displaystyle \operatorname {E} (\operatorname {Var} [X\mid Y])=\sum _{i}p_{i}\sigma _{i}^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc52b9938aac880c80b76dfe0bacc302c1d0f1d3)

![{\displaystyle \sigma _{i}^{2}=\operatorname {Var} [X\mid Y=y_{i}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f02e555171b20f14167f31a43ad480f720a6fa6)

![{\displaystyle \operatorname {Var} (\operatorname {E} [X\mid Y])=\sum _{i}p_{i}\mu _{i}^{2}-\left(\sum _{i}p_{i}\mu _{i}\right)^{2}=\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/069ee9f564216faf173487039b77447b1ef07da2)

![{\displaystyle \mu _{i}=\operatorname {E} [X\mid Y=y_{i}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0df777aa646f81fb52b31a3e13f983747fac39dd)

![{\displaystyle \operatorname {Var} [X]=\sum _{i}p_{i}\sigma _{i}^{2}+\left(\sum _{i}p_{i}\mu _{i}^{2}-\mu ^{2}\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5653ed0b0a55e26b4763766d3e118bc05ed569f4)

![{\displaystyle \operatorname {Var} \left[f(X)\right]\approx \left(f'(\operatorname {E} \left[X\right])\right)^{2}\operatorname {Var} \left[X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c58412ffa8fdf818b89bafb3318c4ace7cd8e9b)

![{\displaystyle {\begin{aligned}\sigma ^{2}&={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}-\mu \right)^{2}={\frac {1}{N}}\sum _{i=1}^{N}\left(x_{i}^{2}-2\mu x_{i}+\mu ^{2}\right)\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-2\mu \left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)+\mu ^{2}\\[5pt]&=\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\mu ^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e37c1ee507b7c4281e55b812bc3cc4f9b29f490c)

![{\displaystyle {\begin{aligned}{\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}-x_{j}\right)^{2}&={\frac {1}{2N^{2}}}\sum _{i,j=1}^{N}\left(x_{i}^{2}-2x_{i}x_{j}+x_{j}^{2}\right)\\[5pt]&={\frac {1}{2N}}\sum _{j=1}^{N}\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}^{2}\right)-\left({\frac {1}{N}}\sum _{i=1}^{N}x_{i}\right)\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}\right)\\[5pt]&\quad +{\frac {1}{2N}}\sum _{i=1}^{N}\left({\frac {1}{N}}\sum _{j=1}^{N}x_{j}^{2}\right)\\[5pt]&={\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)-\mu ^{2}+{\frac {1}{2}}\left(\sigma ^{2}+\mu ^{2}\right)\\[5pt]&=\sigma ^{2}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df68fc666921dd44fea9b6cb04271f239140f4d3)

![{\displaystyle {\begin{aligned}\operatorname {E} [\sigma _{Y}^{2}]&=\operatorname {E} \left[{\frac {1}{n}}\sum _{i=1}^{n}\left(Y_{i}-{\frac {1}{n}}\sum _{j=1}^{n}Y_{j}\right)^{2}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\operatorname {E} \left[Y_{i}^{2}-{\frac {2}{n}}Y_{i}\sum _{j=1}^{n}Y_{j}+{\frac {1}{n^{2}}}\sum _{j=1}^{n}Y_{j}\sum _{k=1}^{n}Y_{k}\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}\operatorname {E} [Y_{i}^{2}]-{\frac {2}{n}}\sum _{j\neq i}\operatorname {E} [Y_{i}Y_{j}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\sum _{k\neq j}^{n}\operatorname {E} [Y_{j}Y_{k}]+{\frac {1}{n^{2}}}\sum _{j=1}^{n}\operatorname {E} [Y_{j}^{2}]\right]\\[5pt]&={\frac {1}{n}}\sum _{i=1}^{n}\left[{\frac {n-2}{n}}(\sigma ^{2}+\mu ^{2})-{\frac {2}{n}}(n-1)\mu ^{2}+{\frac {1}{n^{2}}}n(n-1)\mu ^{2}+{\frac {1}{n}}(\sigma ^{2}+\mu ^{2})\right]\\[5pt]&={\frac {n-1}{n}}\sigma ^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/587c23d5bb641523e823629ee7d68f4751fa7db0)

![{\displaystyle \operatorname {Var} [s^{2}]=\operatorname {Var} \left({\frac {\sigma ^{2}}{n-1}}\chi _{n-1}^{2}\right)={\frac {\sigma ^{4}}{(n-1)^{2}}}\operatorname {Var} \left(\chi _{n-1}^{2}\right)={\frac {2\sigma ^{4}}{n-1}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d1240e22b54bede05c0d8ab0c9a0479a5583e222)

![{\displaystyle \operatorname {E} [S^{2}]=\sigma ^{2},\quad \operatorname {Var} [S^{2}]={\frac {\sigma ^{4}}{n}}\left((\kappa -1)+{\frac {2}{n-1}}\right)={\frac {1}{n}}\left(\mu _{4}-{\frac {n-3}{n-1}}\sigma ^{4}\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/87875bbe670adb5e479b3845a85431d0130e3049)

![{\displaystyle \operatorname {E} \left[(x-\mu )(x-\mu )^{*}\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c7cc7933557809745e2928b688000d26478bde22)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\operatorname {T} }\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bab02d13f2da96c2bbc93990454fa364ffea6b)

![{\displaystyle \operatorname {E} \left[(X-\mu )(X-\mu )^{\dagger }\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b430afe926947268de35955a46b5977edadd6a)

![{\displaystyle \operatorname {E} \left[(X-\mu )^{\operatorname {T} }(X-\mu )\right]=\operatorname {tr} (C),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/483e02bc316e8ecfeac1c71f1b2464b4ece2f45c)